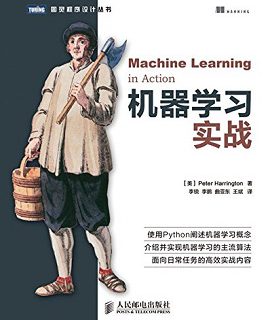

基本信息

- 出版社 : 人民邮电出版社; 第1版 (2014年7月23日)

- 出版日期 : 2013年6月1日

- 品牌 : 图灵社区

- 语言 : 简体中文

- 文件大小 : 6409 KB

- 纸书页数 : 315页

- Peter Harrington (作者), 李锐 (译者), 李鹏 (译者), 曲亚东 (译者), 王斌 (译者)

- 下载格式:azw3、epub、mobi

编辑推荐

介绍并实现机器学习的主流算法

面向日常任务的高效实战内容

《机器学习实战》没有从理论角度来揭示机器学习算法背后的数学原理,而是通过“原理简述+问题实例+实际代码+运行效果”来介绍每一个算法。学习计算机的人都知道,计算机是一门实践学科,没有真正实现运行,很难真正理解算法的精髓。这本书的好处就是边学边用,非常适合于急需迈进机器学习领域的人员学习。实际上,即使对于那些对机器学习有所了解的人来说,通过代码实现也能进一步加深对机器学习算法的理解。

《机器学习实战》的代码采用Python语言编写。Python代码简单优雅、易于上手,科学计算软件包众多,已经成为不少大学和研究机构进行计算机教学和科学计算的语言。相信Python编写的机器学习代码也能让读者尽快领略到这门学科的精妙之处。

内容简介

机器学习是人工智能研究领域中一个极其重要的研究方向,在现今的大数据时代背景下,捕获数据并从中萃取有价值的信息或模式,成为各行业求生存、谋发展的决定性手段,这使得这一过去为分析师和数学家所专属的研究领域越来越为人们所瞩目。

《机器学习实战》主要介绍机器学习基础,以及如何利用算法进行分类,并逐步介绍了多种经典的监督学习算法,如k近邻算法、朴素贝叶斯算法、Logistic回归算法、支持向量机、AdaBoost集成方法、基于树的回归算法和分类回归树(CART)算法等。第三部分则重点介绍无监督学习及其一些主要算法:k均值聚类算法、Apriori算法、FP-Growth算法。第四部分介绍了机器学习算法的一些附属工具。

《机器学习实战》通过精心编排的实例,切入日常工作任务,摒弃学术化语言,利用高效的可复用Python代码来阐释如何处理统计数据,进行数据分析及可视化。通过各种实例,读者可从中学会机器学习的核心算法,并能将其运用于一些策略性任务中,如分类、预测、推荐。另外,还可用它们来实现一些更高级的功能,如汇总和简化等。

作者简介

Peter Harrington,拥有电气工程学士和硕士学位,他曾经在美国加州和中国的英特尔公司工作7年。Peter拥有5项美国专利,在三种学术期刊上发表过文章。他现在是Zillabyte公司的首席科学家,在加入该公司之前,他曾担任2年的机器学习软件顾问。Peter在业余时间还参加编程竞赛和建造3D打印机。

媒体评论

“易学易懂,用处很大。”

——Alexandre Alves,Oracle CEP的架构师

“精心织构的代码完美地诠释出机器学习的核心要义。”

——Patrick Toohey,Mettler-Toledo Hi-Speed软件工程师

“实例很棒!可用于任何领域!”

——John Griffin,Hibernate Search in Action一书的合作者

“叙述循序渐进,巧妙地阐述了算法之间的差异。”

——Stephen McKamey,Isomer Innovations技术实践总监前言 大学毕业后,我先后在加利福尼亚和中国大陆的Intel公司工作。最初,我打算工作两年之后回学校读研究生,但是幸福时光飞逝而过,转眼就过去了六年。那时,我意识到我必须回到校园。我不想上夜校或进行在线学习,我就想坐在大学校园里吸纳学校传授的所有知识。在大学里,最好的方面不是你研修的课程或从事的研究,而是一些外围活动:与人会面、参加研讨会、加入组织、旁听课程,以及学习未知的知识。

在2008年,我帮助筹备一个招聘会。我同一个大型金融机构的人交谈,他们希望我去应聘他们机构的一个对信用卡建模(判断某人是否会偿还贷款)的岗位。他们问我对随机分析了解多少,那时,我并不能确定“随机”一词的意思。他们提出的工作地点令我无法接受,所以我决定不再考虑了。但是,他们说的“随机”让我很感兴趣,于是我拿来课程目录,寻找含有“随机”字样的课程,我看到了“离散随机系统”。我没有注册就直接旁听了这门课,完成课后作业,参加考试,最终被授课教授发现。但是她很仁慈,让我继续学习,这让我非常感激。上这门课,是我第一次看到将概率应用到算法中。在这之前,我见过一些算法将平均值作为外部输入,但这次不同,方差和均值都是这些算法中的内部值。这门课主要讨论时间序列数据,其中每一段数据都是一个均匀间隔样本。我还找到了名称中包含“机器学习”的另一门课程。该课程中的数据并不假设满足时间的均匀间隔分布,它包含更多的算法,但严谨性有所降低。再后来我意识到,在经济系、电子工程系和计算机科学系的课程中都会讲授类似的算法。

2009年初,我顺利毕业,并在硅谷谋得了一份软件咨询的工作。接下来的两年,我先后在涉及不同技术的八家公司工作,发现了最终构成这本书主题的两种趋势:第一,为了开发出竞争力强的应用,不能仅仅连接数据源,而需要做更多事情;第二,用人单位希望员工既懂理论也能编程。

程序员的大部分工作可以类比于连接管道,所不同的是,程序员连接的是数据流,这也为人们带了巨大的财富。举一个例子,我们要开发一个在线出售商品的应用,其中主要部分是允许用户来发布商品并浏览其他人发布的商品。为此,我们需要建立一个Web表单,允许用户输入所售商品的信息,然后将该信息传到一个数据存储区。要让用户看到其他用户所售商品的信息,就要从数据存储区获取这些数据并适当地显示出来。我可以确信,人们会通过这种方式挣钱,但是如果让要应用更好,需要加入一些智能因素。这些智能因素包括自动删除不适当的发布信息、检测不正当交易、给出用户可能喜欢的商品以及预测网站的流量等。为了实现这些目标,我们需要应用机器学习方法。对于最终用户而言,他们并不了解幕后的“魔法”,他们关心的是应用能有效运行,这也是好产品的标志。

一个机构会雇用一些理论家(思考者)以及一些做实际工作的人(执行者)。前者可能会将大部分时间花在学术工作上,他们的日常工作就是基于论文产生思路,然后通过高级工具或数学进行建模。后者则通过编写代码与真实世界交互,处理非理想世界中的瑕疵,比如崩溃的机器或者带噪声的数据。完全区分这两类人并不是个好想法,很多成功的机构都认识到这一点。(精益生产的一个原则就是,思考者应该自己动手去做实际工作。)当招聘经费有限时,谁更能得到工作,思考者还是执行者?很可能是执行者,但是现实中用人单位希望两种人都要。很多事情都需要做,但当应用需要更高要求的算法时,那么需要的人员就必须能够阅读论文,领会论文思路并通过代码实现,如此反复下去。

在这之前,我没有看到在机器学习算法方面缩小思考者和执行者之间差距的书籍。本书的目的就是填补这个空白,同时介绍机器学习算法的使用,使得读者能够构建更成功的应用。

精彩书摘

7.1.1 bagging:基于数据随机重抽样的分类器构建方法

自举汇聚法(bootstrap aggregating),也称为bagging方法,是在从原始数据集选择S次后得到S个新数据集的一种技术。新数据集和原数据集的大小相等。每个数据集都是通过在原始数据集中随机选择一个样本来进行替换而得到的①。这里的替换就意味着可以多次地选择同一样本。这一性质就允许新数据集中可以有重复的值,而原始数据集的某些值在新集合中则不再出现。

在S个数据集建好之后,将某个学习算法分别作用于每个数据集就得到了S个分类器。当我们要对新数据进行分类时,就可以应用这S个分类器进行分类。与此同时,选择分类器投票结果中最多的类别作为最后的分类结果。

当然,还有一些更先进的bagging方法,比如随机森林(random forest)。有关这些方法的一个很好的讨论材料参见网页接下来我们将注意力转向一个与bagging类似的集成分类器方法boosting。

7.1.2 boosting

boosting是一种与bagging很类似的技术。不论是在boosting还是bagging当中,所使用的多个分类器的类型都是一致的。但是在前者当中,不同的分类器是通过串行训练而获得的,每个新分类器都根据已训练出的分类器的性能来进行训练。boosting是通过集中关注被已有分类器错分的那些数据来获得新的分类器。

由于boosting分类的结果是基于所有分类器的加权求和结果的,因此boosting与bagging不太一样。bagging中的分类器权重是相等的,而boosting中的分类器权重并不相等,每个权重代表的是其对应分类器在上一轮迭代中的成功度。

boosting方法拥有多个版本,本章将只关注其中一个最流行的版本AdaBoost。

下面我们将要讨论AdaBoost背后的一些理论,并揭示其效果不错的原因。

7.2训练算法:基于错误提升分类器的性能

能否使用弱分类器和多个实例来构建一个强分类器?这是一个非常有趣的理论问题。这里的“弱”意味着分类器的性能比随机猜测要略好,但是也不会好太多。这就是说,在二分类情况下弱分类器的错误率会高于50%,而“强”分类器的错误率将会低很多。AdaBoost算法即脱胎于上述理论问题。

AdaBoost是adaptive boosting(自适应boosting)的缩写,其运行过程如下:训练数据中的每个样本,并赋予其一个权重,这些权重构成了向量D。一开始,这些权重都初始化成相等值。首先在训练数据上训练出一个弱分类器并计算该分类器的错误率,然后在同一数据集上再次训练弱分类器。在分类器的第二次训练当中,将会重新调整每个样本的权重,其中第一次分对的样本的权重将会降低,而第一次分错的样本的权重将会提高。为了从所有弱分类器中得到最终的分类结果,AdaBoost为每个分类器都分配了一个权重值alpha,这些alpha值是基于每个弱分类器的错误率进行计算的。其中,错误率ε的定义为:

而alpha的计算公式如下:

AdaBoost算法的流程如图7—1所示。